KI Note veröffentlicht Bericht zu Data Analytics in der Sparkasse KölnBonn

Artikel ursprünglich veröffentlicht auf: KINOTE

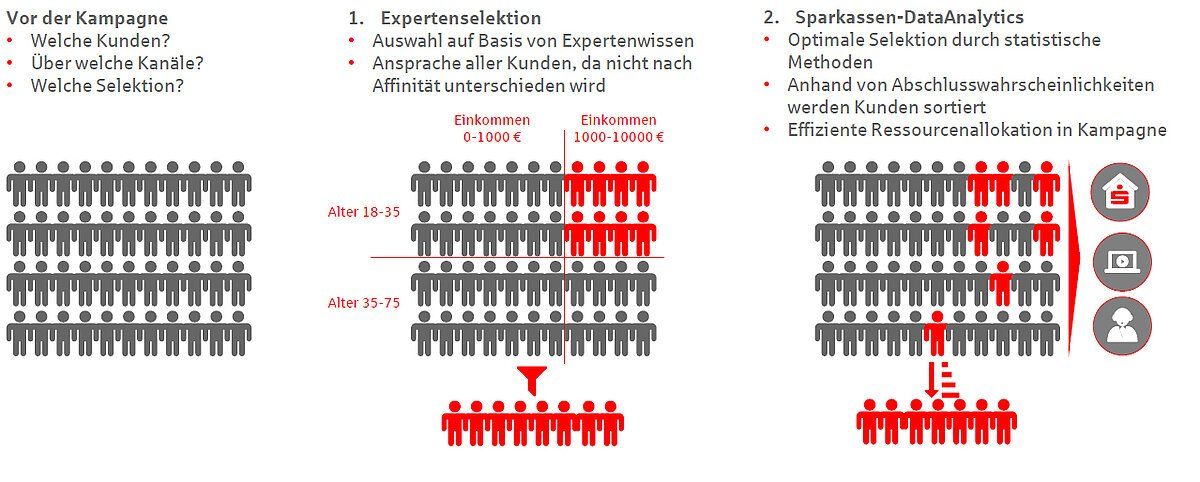

Kampagnenbasis: Expertenselektion im Vergleich zu algorithmisch-basierter Kundenansprache. (Quelle: Sparkasse KölnBonn)

Welche Algorithmen geeignet sind, Kundenpräferenzen zu erkennen, wird in den folgenden Abschnitten skizziert.

Algorithmen und Methoden

Für das Trainieren der Prognosemodelle werden vor allem historische Kundendaten als Merkmale herangezogen, die einen Einfluss auf die Produktaffinität haben können. Merkmale sind etwa: Alter, Salden und bereits vorhandene Produkte des Kunden. Es werden aber auch Informationen aus den Zahlungsverkehrsdaten genutzt, sofern dies unter Datenschutz-Gesichtspunkten möglich ist. Im Ergebnis nutzt das Modell einen Merkmalsvektor mit sämtlichen Informationen, die zur Prognose eines Produktkaufs benötigt werden.

Die relevante Zielgröße für das Training sind sogenannte Kauf-Kennzeichen: Alle Kunden, die im Trainingszeitraum das Zielprodukt abschließen, werden codiert. Mit diesem aufbereiteten Datensatz wird das Modelltraining durchgeführt. Dabei werden nichtlineare Zusammenhänge zwischen den Merkmalen und der Zielgröße abgeleitet und nur diejenigen Merkmale einer Person berücksichtigt, die einen positiven Beitrag zur Prognosegüte liefern.

So kommen etwa Entscheidungsbäume zum Einsatz, die den Datensatz entlang binärer Splits der Kundenmerkmale trennen. Splits können so zum Beispiel anhand der folgenden Entscheidungsfragen charakterisiert werden: „Ist der Kunde älter als 45 Jahre?“ oder „Wohnt der Kunde zur Miete?“. Am Ende dieser Fragenkette wird jeder Verbraucher einem Segment zugeteilt, das eine bestimmte Abschlusswahrscheinlichkeit für das untersuchte Produkt aufweist.

Ein einzelner Entscheidungsbaum müsste sehr groß werden, um die vorliegen de Komplexität hinreichend abzubilden. Zudem wäre das Modell auf Basis eines einzigen komplexen Baumes anfällig für das Erlernen von zufälligen Fluktuationen der Stichprobe, die für das Training zur Verfügung steht.

Boosted Trees

Das bedeutet: Während ein einzelner komplexer Entscheidungsbaum die Charakteristika des zugrundeliegenden Trainings-Datensatzes mit einer hohen Detailtiefe abbildet, könnte er für die Prognose zu einem zweiten Kundendatensatz ungeeignet sein, da der Entscheidungsbaum etwaige Besonderheiten des Trainingsdatensatzes zu stark gewichtet. Diese Problematik wird gelöst, indem die maximale Tiefe des Entscheidungsbaums stark begrenzt wird. Die Zahl an Fragen, die zu einem Kunden gestellt werden, kann zum Beispiel auf fünf beschränkt werden. Die damit einhergehende Verringerung der Modellqualität wird anschließend durch eine weitere Methode, das Boosting, verbessert.

Die Idee des Boosting ist es, eine Vielzahl einfacher Modellen in ein starkes Ensemble-Modell zu überführen. Das heißt, dass in einem iterativen Prozess eine Vielzahl an Bäumen erzeugt wird. Bei der Erzeugung wird jeder neue Baum darauf optimiert, die Schwächen des bisherigen „Waldes“ zu korrigieren. Jeder einzelne Baum besitzt zwar nur eine geringe Prognosefähigkeit, in der Summe liefern alle Bäume jedoch sehr gute Resultate.

Methodischer Ausblick

Boosted Trees erlauben keine intuitive Interpretation, wie die jeweilige Affinität des Kunden bestimmt worden ist. Anders als bei einfachen Entscheidungsbäumen oder bei linearen Modellen kann aufgrund der Vielzahl an Bäumen der Grund, weshalb der Kunde affin ist, nicht ohne Weiteres erkannt werden. Mit der Nutzung eines darauf aufbauenden Modells können wesentliche Treiber der Modellklassifikation erkannt werden und so den Kundenberatern auch die richtigen Schlagwörter an die Hand gegeben werden, die für die Kundenansprache nutzbar sind.

Eine weitere Entwicklung ist das Schließen des Closed Loops. Dazu werden die Reaktionen der Verbraucher auf die Ansprache nicht nur zuverlässig erfasst, sondern auch zurückgespielt. Zum einen kann dadurch eine vereinheitlichte Erfolgsmessung der Kampagnen für alle Institute erfolgen. Zum anderen wird es möglich sein, die Affinitätsmodelle kontinuierlich zu verbessern.

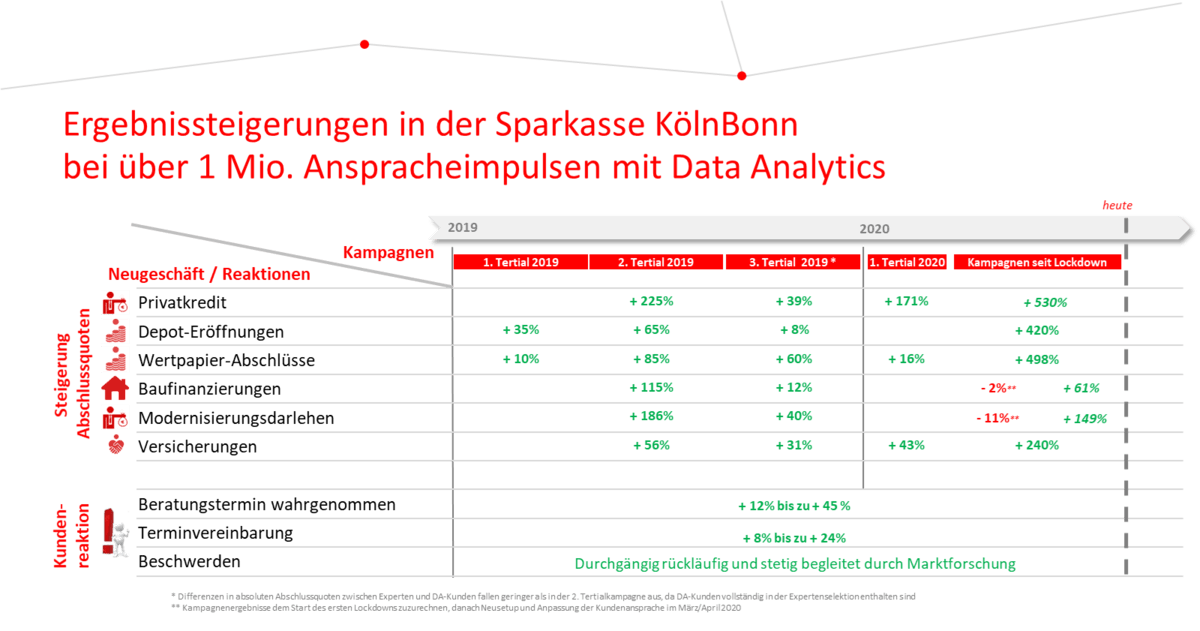

Wurde die Kundenansprache um im Zentrum stehende Data-Analytics-Modelle herum aufgebaut, lassen sich rasch bemerkenswerte Verbesserungen realisieren. Als Beispiel dient die Sparkasse KölnBonn (SKB), die nur noch auf Data-Analytics-basierte Kampagnenansprachen setzt. In allen Ansprachen, die teils über mehrere Kanäle wie App, Online Banking, CallCenter oder Berater bis hin zu E-Mail und Brief gesendet wurden, zeigen sich zusammenfassend zwei positive Effekte: Verbraucher spiegeln viel häufiger zurück, dass das von der Sparkasse angesprochene Thema für sie passt – die Ansprache ist für Kunden also relevant und nicht störend. Schließlich kann das Institut durch die passende Ansprache seine Ressourcen deutlich besser einsetzen und somit viel häufiger Produktabschlüsse realisieren.

Verbesserung der Kundenansprache durch Data Analytics. (Quelle: Sparkasse KölnBonn)Verbesserung der Kundenansprache durch Data Analytics. (Quelle: Sparkasse KölnBonn)

Fazit

Mit Data Analytics, also der Algorithmus-basierten Kundenansprache, lassen sich rasch Erfolge erzielen und die Relevanz der Schnittstelle Kunde-Bank erheblich aufwerten. Nach den Ersterfolgen ist es für ein Institut von zentraler Bedeutung, seine Touchpoints, also die Kanäle, auf denen es seine Kunden erreichen kann, optimal aufeinander abzustimmen und die Kundenansprache zu orchestrieren. Innerhalb des Instituts wird es im Laufe der Data-Analytics-Nutzung zunehmend wichtig, kontinuierlich Transparenz über die neuen Vorgehensmodelle und das Erreichte zu gewährleisten.

Auch das Stakeholdermanagement darf nicht vernachlässigt werden, da die Umstellung eines Kampagnenmanagements auf Data Analytics einem Change Prozess entspricht, in dem teils jahrelange, wenn nicht sogar jahrzehntelang gelebte Praxis der Experten-basierten Kundenansprache auf moderne datenanalytische Methoden trifft. Über den abschließenden Erfolg einer Data-Analytics-Integration wird daher nicht die Modellgüte von Algorithmen entscheiden, sondern vielmehr, wie der organisatorische Wandel in einem Institut begleitet wird.

Hier die Diskussion des Artikels auf LinkedIn

Teilen

Auf dem neuesten Stand bleiben

Registrieren Sie sich und Sie werden stets über Neuigkeiten informiert.